Apache Spark es una herramienta poderosa en el arsenal de cualquier desarrollador de soluciones tecnológicas, especialmente en d10. Conocido por su velocidad y facilidad de uso, Spark facilita el procesamiento de grandes volúmenes de datos. Su capacidad para gestionar análisis complejos y su adaptabilidad a diversos entornos lo convierten en un pilar fundamental para los proyectos de Big Data.

Spark fue desarrollado inicialmente en la Universidad de California en Berkeley en 2009 como parte de un proyecto de investigación. Rápidamente ganó popularidad y se convirtió en un proyecto de código abierto en 2010. Desde entonces, ha evolucionado significativamente, integrándose perfectamente en la industria del desarrollo de software, especialmente en áreas donde la gestión eficiente de grandes cantidades de datos es crucial.

Características de Apache Spark:

Las principales características de Apache Spark incluyen su motor de procesamiento en memoria, que permite un análisis de datos más rápido en comparación con otros sistemas. Además, su capacidad para procesar datos en tiempo real y su compatibilidad con varios lenguajes de programación, como Scala, Python y Java, lo hacen excepcionalmente versátil. Estas características lo convierten en una herramienta indispensable en los proyectos de d10, permitiendo una gestión de datos eficiente y flexible.

Uso:

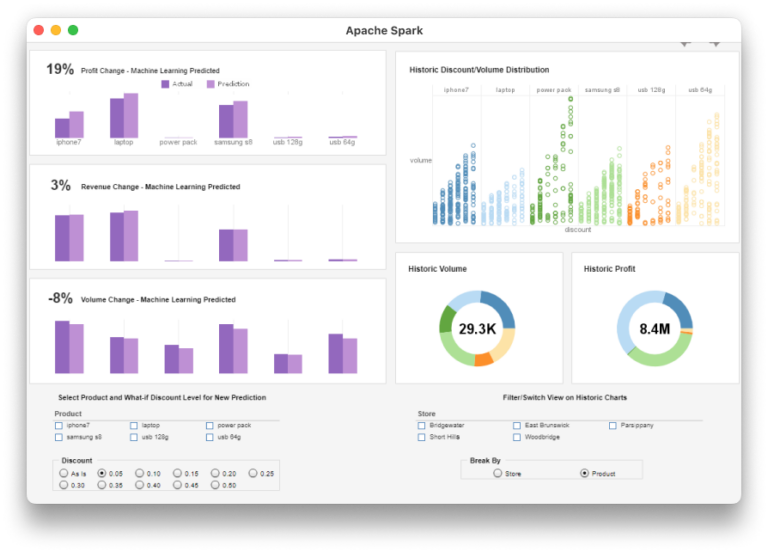

En d10, Apache Spark se utiliza en una amplia variedad de proyectos, desde desarrollo personalizado hasta ciencia de datos y aprendizaje profundo. Por ejemplo, se emplea para procesar grandes volúmenes de datos en proyectos de análisis predictivo, para el procesamiento de datos en tiempo real que permite la toma de decisiones instantáneas, y para la integración de sistemas de aprendizaje profundo en análisis avanzados.

Ventajas:

Los beneficios de usar Apache Spark en d10 incluyen una mayor eficiencia en el procesamiento de datos, la capacidad de manejar grandes volúmenes de información, una mejor escalabilidad y seguridad. Estas ventajas permiten al equipo de d10 desarrollar soluciones más robustas y eficientes, optimizando tanto los recursos como el tiempo.

Desafíos:

A pesar de sus numerosas ventajas, Apache Spark presenta algunos desafíos, como la complejidad en la gestión de recursos y la necesidad de contar con hardware potente para un funcionamiento óptimo. En d10, estos desafíos se abordan mediante una planificación y gestión cuidadosa de los recursos, así como una inversión constante en infraestructura.

Integración:

Apache Spark se integra perfectamente con diversas herramientas y tecnologías en d10 para la creación de soluciones holísticas. Algunas de las principales integraciones incluyen:

- Hadoop: Para el almacenamiento y procesamiento de datos.

- Kafka: Para el procesamiento de datos en tiempo real.

- Jupyter: Para la exploración de datos y el Machine Learning.

- Docker: Para el despliegue y la gestión de aplicaciones.

Evolución:

En el futuro, se espera que Apache Spark continúe evolucionando con mejoras en su eficiencia, en sus capacidades de procesamiento en tiempo real y en el soporte para más lenguajes y frameworks. Estas actualizaciones garantizarán que Spark siga siendo una herramienta clave para d10 en la gestión de Big Data.

Conclusión:

Apache Spark es una herramienta esencial en el ecosistema tecnológico de d10, proporcionando soluciones avanzadas y eficientes para el análisis de Big Data. Su versatilidad y capacidad de integración con otras tecnologías lo convierten en un componente clave para abordar los desafíos de la gestión de grandes volúmenes de datos y para la implementación de soluciones innovadoras.

Referencias y recursos adicionales:

¿Listo para pasar a la acción?

Para iniciar una conversación, completa este formulario indicando cuándo deseas ser llamado.