Apache Airflow es una herramienta de código abierto diseñada para orquestar y automatizar workflows de datos. Permite a las empresas planificar, ejecutar y supervisar pipelines de datos complejos. En d10, Apache Airflow se utiliza para optimizar los procesos ETL, garantizar la fiabilidad de los flujos de datos y mejorar la escalabilidad de las infraestructuras analíticas.

Desde su introducción por Airbnb en 2014, Apache Airflow se ha consolidado como una referencia en el ámbito de la orquestación de workflows gracias a su enfoque modular, su extensibilidad y su integración con numerosas herramientas de ingeniería de datos.

Depuis son introduction par Airbnb en 2014, Apache Airflow s’est imposé comme une référence dans le domaine de l’orchestration des workflows grâce à son approche modulaire, son extensibilité et son intégration avec de nombreux outils de data engineering.

Características de Apache Airflow

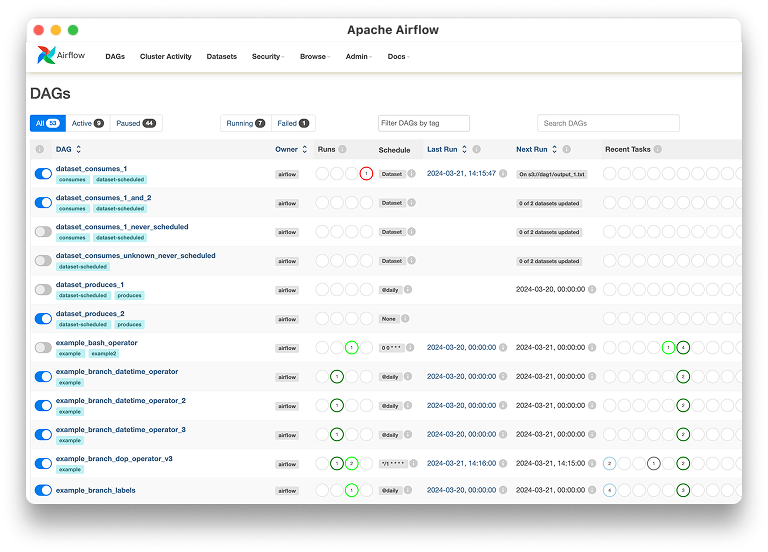

Apache Airflow ofrece funcionalidades avanzadas como la gestión de dependencias entre tareas, una planificación flexible, la visualización de workflows y una API REST para automatizar las ejecuciones. Su flexibilidad permite integrar scripts en Python, SQL y otras tecnologías para responder a las diversas necesidades de las empresas.

Uso de Apache Airflow en d10

En d10, Apache Airflow se utiliza en varios ámbitos:

- Orquestación de pipelines de datos: Automatización de workflows ETL e integración de múltiples fuentes.

- Procesamiento de datos en tiempo real: Gestión de flujos de datos con Apache Kafka y Spark.

- Supervisión y alertas: Seguimiento de ejecuciones y notificaciones en caso de fallos.

- Escalabilidad y gestión de recursos: Optimización de recursos en la nube y on-premise.

Ventajas de Apache Airflow

El uso de Apache Airflow en d10 permite estandarizar y automatizar los flujos de datos, mejorar la transparencia de los procesos y garantizar la reproducibilidad de los análisis. Su interfaz web facilita la gestión y supervisión de los workflows.

Desafíos

Aunque es una herramienta potente, Apache Airflow presenta algunos desafíos, como la curva de aprendizaje para nuevos usuarios, la gestión de dependencias entre tareas complejas y la optimización del rendimiento en pipelines de gran volumen. d10 acompaña a sus clientes en la implementación y optimización de workflows con Airflow.

Integraciones

Apache Airflow se integra con varias herramientas clave utilizadas en d10, entre ellas:

- Google Cloud Composer y AWS MWAA para la ejecución nativa en la nube.

- Apache Spark y Databricks para el procesamiento de datos distribuidos.

- PostgreSQL y BigQuery para la gestión de bases de datos analíticas.

- Slack y PagerDuty para notificaciones y gestión de incidentes.

Evolución

El futuro de Apache Airflow en d10 se basa en la mejora de sus capacidades de integración con inteligencia artificial, la optimización de los tiempos de ejecución y la adopción creciente de arquitecturas serverless para una gestión aún más eficiente de los workflows.

Conclusión

Apache Airflow es una herramienta esencial en d10 para la orquestación y automatización de workflows de datos. Su flexibilidad, extensibilidad y su rico ecosistema la convierten en una solución imprescindible para las empresas que desean estructurar e industrializar sus pipelines analíticos.

¿Listo para pasar a la acción?

Para iniciar una conversación, completa este formulario indicando cuándo deseas ser llamado.