Apache Airflow est un outil open-source conçu pour orchestrer et automatiser les workflows de données. Il permet aux entreprises de planifier, exécuter et surveiller des pipelines de données complexes. Chez d10, Apache Airflow est utilisé pour optimiser les processus ETL, assurer la fiabilité des flux de données et améliorer la scalabilité des infrastructures analytiques.

Depuis son introduction par Airbnb en 2014, Apache Airflow s’est imposé comme une référence dans le domaine de l’orchestration des workflows grâce à son approche modulaire, son extensibilité et son intégration avec de nombreux outils de data engineering.

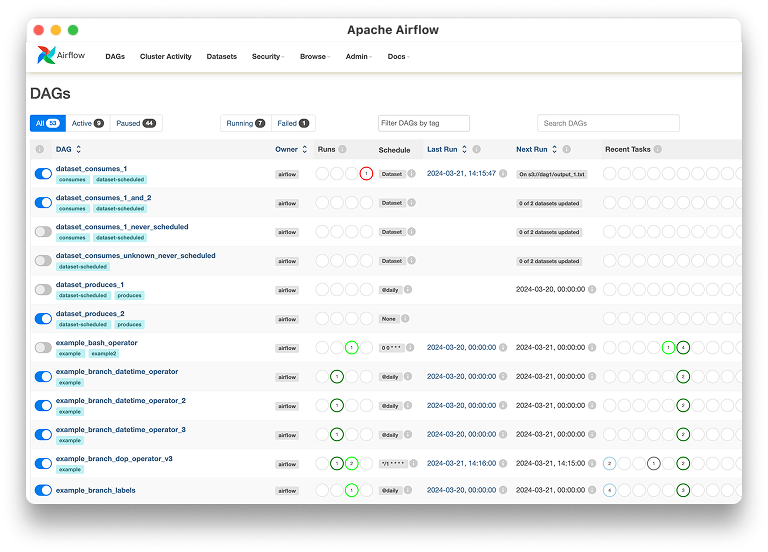

Caractéristiques de Apache Airflow :

Utilisation :

Chez d10, Apache Airflow est exploité dans plusieurs domaines :

Orchestration des pipelines de données : Automatisation des workflows ETL et intégration de sources multiples.

Traitement des données en temps réel : Gestion des flux de données avec Apache Kafka et Spark.

Monitoring et alertes : Suivi des exécutions et notification en cas d’échec.

Scalabilité et gestion des ressources : Optimisation des ressources cloud et on-premise.

Avantages :

Défis :

Intégration :

Apache Airflow s’intègre avec plusieurs outils clés utilisés chez d10, notamment :

Google Cloud Composer et AWS MWAA pour l’exécution cloud native.

Apache Spark et Databricks pour le traitement des données distribuées.

PostgreSQL et BigQuery pour la gestion des bases de données analytiques.

Slack et PagerDuty pour les notifications et la gestion des incidents.

Évolution :

Conclusion :

Apache Airflow est un outil essentiel chez d10 pour l’orchestration et l’automatisation des workflows de données. Sa flexibilité, son extensibilité et son écosystème riche en font une solution incontournable pour les entreprises souhaitant structurer et industrialiser leurs pipelines analytiques.

Envie de passer à l'action ?

Pour lancer une conversation, complétez ce formulaire en indiquant quand vous souhaitez être appelé.